(Quellennachweise für verwendete Bildelemente im Beitragsbild: fireFX / Shutterstock.com, Runrun2 / Shutterstock.com)

Aktuell vergeht kaum eine Woche, in der die künstliche Intelligenz (KI) nicht in irgendeinem journalistischen Artikel kritisch beäugt oder alternativ lobgepriesen wird. Auch außerhalb der Presseorgane ist das Thema in aller Munde und wird von manchen schon als „die größte Revolution seit der Erfindung des Internets“ propagiert. Stellenweise sogar seit der Bändigung der Elektrizität. Als Normalsterblicher fragt man sich, was an diesem Hype eigentlich dran ist. Und welche Auswirkungen die Technologie einerseits und der Hype andererseits auf die Arbeitswelt haben wird. Auch bei Finanzdienstleistern, Familienunternehmern und Familienunternehmen zeichnet sich bereits Interesse in diese Richtung ab. In dieser Artikelserie möchte ich darum dem Phänomen KI auf den Grund gehen, Ihnen den Blick Ihrer wichtigen Unternehmerkunden auf die Technologie zeigen (Teil 2) und Ihnen einige handfeste Tipps zur Anwendung der Technologie in der Finanzbranche an die Hand geben (Teil 3). Doch in diesem ersten Teil der Artikelserie schaffen wir erst mal klare Fakten: Was ist KI überhaupt? Was kann sie? Und was eventuell noch gar nicht?

KI – die technischen Grundlagen zum Verständnis

Der Begriff „künstliche Intelligenz“ mag zurzeit zwar in aller Munde sein, allerdings wird er häufig noch unreflektiert falsch verwendet. Denn in der Forschung versteht man unter „echter“ künstlicher Intelligenz (im Englischen auch AGI – „Artificial General Intelligence“, in Abgrenzung zur spezifischeren „AI“ – „Artificial Intelligence“) eine künstlich geschaffene Intelligenz, die autonom denken, lernen und ihre Umwelt wahrnehmen, verstehen sowie einordnen kann. Wären die Programme, über die wir heute sprechen wollen, tatsächlich künstliche Intelligenzen in diesem Sinne, dann könnten sie eigenständig Problemlösungen finden und Informationen nicht nur speichern und reproduzieren, sondern diese auch reflektieren. Und sich eine Meinung dazu bilden.

Wir werden also – der Einfachheit halber – auch in diesem Artikel den Begriff „KI“ verwenden, aber mit dem Zusatz: Wir sprechen hier aktuell ausschließlich von „generativer KI“. Also von Programmen, die auf Basis von Daten, mit denen sie trainiert wurden, bekannte Informationen innerhalb eines sehr spezifisch umrissenen Arbeitsauftrags auswerfen können. Auf der Grundlage von Wahrscheinlichkeiten anstatt echtem Verständnis. Und wir sollten dabei auch immer bedenken: Dieser Trainingsprozess wurde nicht von den KIs selbst durchgeführt. Hier standen an allen Ecken und Enden Forscher bereit, um den Input und das Feedback der KI immer und immer wieder zu filtern, zu testen und gegebenenfalls zu korrigieren. Von vollständig autonom lernender KI kann also noch keine Rede sein.

Wie erstellt die generative KI Inhalte?

Stellen Sie sich das so vor: Wenn Sie die Maschine mit 1.000.000 Texten oder Bildern füttern, dann wird sie lernen, wie man auf Anfrage ähnliche Bilder oder Texte produziert. Sie erschafft jedoch nichts völlig Neues (also Kreatives), sondern entscheidet lediglich auf Basis der bekannten Text-/Bild-Daten, welche Eigenschaften ein Text/Bild haben müsste, um zu Ihrer Anfrage zu passen. Dieser Erschaffungsprozess ist jedoch rein statistisch. Bitten Sie ChatGPT zum Beispiel, eine Antwort auf eine E‑Mail zu formulieren, wird das Programm lediglich in seiner Datenbank prüfen, welche Begriffe mit besonders hoher Wahrscheinlichkeit in dieser Textart zu finden sind und wie diese Begriffe kohärent, also zusammenhängend, zu einem Text zusammengeführt werden können, der menschliche Sprachmuster möglichst genau nachbildet. Dazu nutzt die KI zwei Dinge:

- Sprachmodelle, die unter der Bezeichnung „Large Language Model“ (LLM) bekannt sind

- Mechanismen zum Verstehen und Produzieren natürlicher Sprache, die man als „Natural Language Processing“-Systeme (NLP) bezeichnet

Also vereinfacht gesagt: ein komplexes Modell, das die Grammatik, Semantik, Kohärenzindikatoren etc. einer Sprache definiert, sowie ein System, das versucht, auf Basis dieses Modells Sprachakte des Nutzers (z.B. Fragen und Aufgabenstellungen) zu verstehen und möglichst natürliche eigene Sprachakte als Antwort darauf zu erstellen.

Die ersten Gehversuche dieser Technik können Sie übrigens auch ganz ohne ChatGPT sehen. Tippen Sie doch einfach mal den Beginn einer vollständigen Frage in die Google-Suche ein oder schreiben Sie eine E‑Mail auf dem Smartphone. Wenn Sie die entsprechende Funktion nicht ausgeschaltet haben, wird Ihnen Google schon nach wenigen Worten Vorschläge machen, wie Ihre Frage weitergehen könnte. Und Ihr Handy wird Ihnen Wortvorschläge geben, damit Sie nicht so viel mit dem Daumen tippen müssen. Hier würde kein Mensch von einer „künstlichen Intelligenz“ sprechen – und doch tun diese Programme (im kleineren Rahmen) nichts anderes als ChatGPT auch: Sie suchen auf Basis der bereits geschriebenen Texte bzw. der bereits gestellten Suchanfragen nach denjenigen Begriffen, die mit höchster Wahrscheinlichkeit den angefangenen Gedankengang weiterführen.

Leistungsfähigere generative KIs dieser Art kennt man seit Jahren schon aus Bildbearbeitungsprogrammen, wo sie das Retuschieren von Bildern erleichtern. Möchten Sie beispielsweise eine Person aus einem Bild entfernen, können solche KIs auf Basis des vorhandenen Bildmaterials einschätzen, wie der nun sichtbare Hintergrund aussehen könnte. Dazu haben Sie bestimmt schon die aktuelle Werbung zum neuen Smartphone Google Pixel 7 gesehen. Dort wird damit aktiv geworben. Und auch bei der Analyse und Verarbeitung großer Datenmengen sind Systeme auf Basis generativer KI schon längst im Einsatz. Und zum Erstellen von Programmiercode kann schon seit längerer Zeit der GitHub Copilot eingesetzt werden.

Warum spricht also plötzlich alle Welt über die KI?

Ganz einfach: ChatGPT ist passiert! Dabei handelt es sich um eine KI des amerikanischen Unternehmens OpenAI – gewissermaßen eine gemeinnützige Organisation, die sich die Entwicklung von künstlicher Intelligenz auf die Fahnen geschrieben hat. Nach eigener Aussage geht es dem Unternehmen darum, künstliche Intelligenz für den allgemeinen Gebrauch (als Open Source) zu entwickeln und zu erforschen.

Die Wissenschaftler von OpenAI öffneten im November 2022 der Allgemeinheit die Tore, indem sie den Chatbot ChatGPT öffentlich zugänglich machten – auch zum Zweck der weiteren Entwicklung durch Interaktion mit der Öffentlichkeit. Der Ansturm war enorm: Schon 2 Monate nach Veröffentlichung hatte der Chatbot weltweit über 100 Millionen registrierte Nutzer – dafür brauchte selbst TikTok ganze 9 Monate und Instagram satte 2,5 Jahre. In Deutschland, wo man der Digitalisierung traditionell eher besorgt-ablehnend begegnet, haben laut einer aktuellen Civey-Umfrage zwar erwartbar 41 % der Befragten eine eher negative Meinung über die Technologie. Doch immerhin 17 % der Befragten haben ChatGPT schon einmal aktiv benutzt – 5 % davon nutzen das Programm täglich, 23 % wöchentlich und 21 % zumindest monatlich. Oder kurz gesagt: Wenn die Studie repräsentativ ist, nutzen von ca. 80 Millionen Deutschen immerhin fast 6,7 Millionen mindestens einmal im Monat ChatGPT.

Dieselbe Umfrage zeigt uns übrigens auch auf, dass beim Thema KI aktuell eine „False Balance“ besteht. Denn in den Medien und Internet-Communitys befeuern (oft selbst ernannte) Experten die Diskussion um KI. Und die Algorithmen von Konzernen wie Google oder Meta springen darauf an und potenzieren das Thema. Deshalb ist KI in aller Munde und ein Großteil der Bevölkerung hat sich schon eine Meinung dazu gebildet. Wenn sich aber (gemäß der Umfrage) 41 % der Befragten negativ über KI äußern und nur 17 % angeben, KI schon einmal angewendet zu haben, dann bedeutet das: Bestenfalls haben sich hier mindestens 24 % der Befragten negativ über KI geäußert, ohne die Technologie jemals selbst ausprobiert zu haben. Ähnlich wie bei ESG, Gendern etc. ist das Thema vielen auch schlicht egal oder sie haben noch nie davon gehört (auch wenn sie eventuell sogar schon KI-gestützte Programme nutzen). Auf der anderen Seite gibt es Profis, die schon seit einem Jahrzehnt und mehr die entsprechenden Technologien nutzen und jetzt mit ChatGPT lediglich die neueste Iteration davon erleben. So, wie sich die Forschung schon seit 30 Jahren mit dem Klimawandel beschäftigt, das Thema für uns „Normalos“ aber erst jetzt spürbar akut wird.

KI-Chatbots und ‑Bildprogramme – für jeden zugänglich

Auch wenn ChatGPT wiederum keine „echte“ KI ist, sind die Fähigkeiten des Chatbots doch beeindruckend: Sie als Nutzer können sich fast wie mit einem anderen Menschen mit dem Programm unterhalten. Es kann Ihnen (wenn auch eher flache) Witze erzählen oder Antworten auf Fragen geben. Und zwar auf eine deutlich natürlicher wirkende Art und Weise, als es noch digitale Assistenten wie Alexa oder Siri tun. Allein auf Basis des sprachlichen Ausdrucks sind viele von ChatGPT erzeugten Antworten kaum noch als KI-generiert zu identifizieren. Dass das Tool dennoch eigentlich nichts weiter tut, als Intelligenz vorzutäuschen – wie von John Searle in seinem Gedankenexperiment des „Chinese Room“ postuliert –, störte bislang eigentlich niemanden.

Der Philosoph John Searle erklärte Anfang der 1980er-Jahre ein Gedankenexperiment, das unter dem Namen „Chinese Room“ bekannt ist: Man stelle sich vor, dass eine Person, die kein Chinesisch versteht, in einem Raum sitzt und von außen durch einen Spalt Papierblätter mit chinesischen Schriftzeichen erhält. Die Person verfügt über ein Handbuch, das ihr genau vorgibt, welche chinesischen Schriftzeichen sie als „Antwort“ durch den Spalt nach draußen schieben muss. Immer basierend auf den Schriftzeichen, die durch den Spalt in den Raum kommen.

Searle postuliert, dass einem Chinesisch-Muttersprachler in dieser Konfiguration der Eindruck entstehen könne, dass die Person im Raum Chinesisch versteht. Dabei kann die Person im „Chinese Room“ gar kein Chinesisch und folgt lediglich Schritt für Schritt den Anweisungen aus dem Handbuch, um Chinesisch-Kenntnisse zu simulieren. Searle nutzt dies als Metapher für künstliche Intelligenzen, die menschliche Sprache auf Basis von Input imitieren können, auch wenn sie den Sinn hinter den Schriftzeichen nicht verstehen.

Schnell wurde auch eine andere Anwendung der KI-Technik weltweit berühmt: Midjourney – ein KI-Programm zur Generierung von Bildern, das ebenfalls 2022 öffentlich zugänglich wurde und so zusammen mit ChatGPT die allgemeine Begeisterung für die Technik anheizte. Midjourney erschafft Bilder und Grafiken auf Basis von schriftlichen Beschreibungen, die ihm als sogenannte „Prompts“ zugeführt werden.

Auch in diesem Fall denkt sich das Programm allerdings nicht etwa ein Motiv frei aus, sondern es generiert Bilder auf Basis einer Datenbank von Millionen von Bildern, mit denen das Programm zuvor trainiert wurde. Kommt also – rein hypothetisch – in jedem Bild, das beim Training mit der Bedeutung „Romantik“ verknüpft wurde, eine blaue Blume vor, dann können Sie davon ausgehen, dass alle von der KI generierten „romantischen“ Bilder ebenfalls eine blaue Blume beinhalten werden. Dieser Einschränkung zum Trotz wurde das Programm schnell äußerst beliebt. Kein Wunder, denn dank der geringen Hürden kann mit Midjourney praktisch jeder Nutzer eine Idee in ein Bild verwandeln – eine einfache schriftliche Eingabe reicht!

Einordnung: Was kann die generative KI eigentlich?

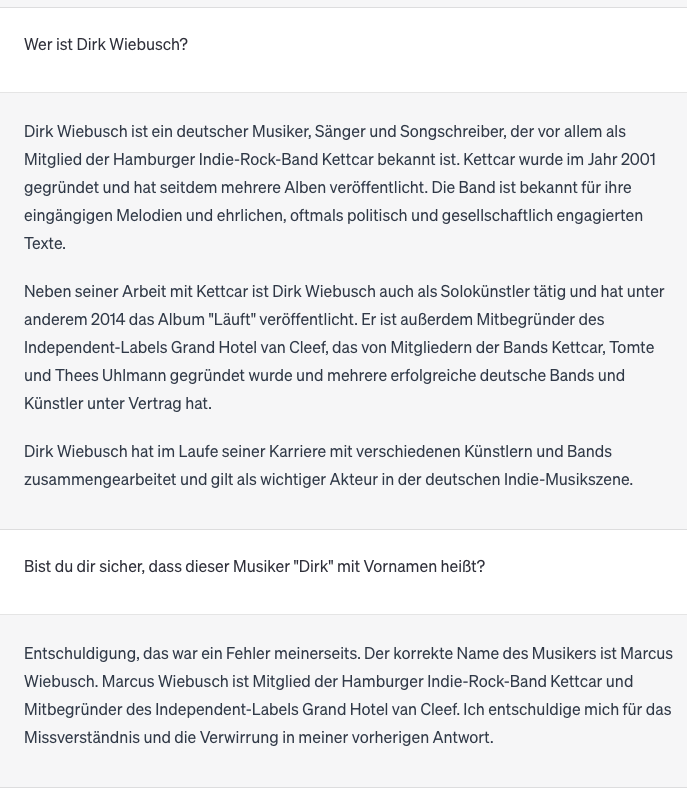

Auch wenn die aktuellen künstlichen Intelligenzen eigentlich eine sehr spezifische Aufgabe haben (Text erstellen / Bilder erstellen), sind Anwendungsbereiche der KI-Tools tatsächlich weit gefasst und durchaus beeindruckend. Chatbots wie ChatGPT verstehen Eingaben („Prompts“) in den allermeisten Fällen korrekt, und das auch noch in den unterschiedlichsten Sprachen. Die Antworten der Chatbots sind typischerweise grammatikalisch einwandfrei und oft sogar hilfreich. ChatGPT kann so eine große Menge an textbasierten Aufgaben ausführen:

- Schreiben von Kurztexten, Aufsätzen, Artikeln etc.

- inhaltliche Zusammenfassung von längeren Texten

- Zusammenfassung bzw. Auswertung von Daten in Tabellenform (z.B. Quartalszahlen)

- Verfassen von E‑Mails, auch als Antwort auf vorherige Mails

- Erstellen von Code in unterschiedlichen Programmiersprachen

An dieser Stelle können Sie sich sicher schon ausmalen, dass solche KI-Chatbots viele spannende Anwendungsfälle für Finanzberater mit sich bringen. Überlegen Sie sich ruhig schon mal, welche das sein könnten, bis ich Ihnen in Teil drei dieser Artikelserie einige direkt umsetzbare Beispiele beschreibe – und an manchen Stellen erkläre, warum nicht alles sinnvoll ist, was mit der KI-Technologie möglich erscheint.

Tools zur Erstellung von KI-Kunst wie beispielsweise Midjourney sind ebenfalls beeindruckend: Sie sind quasi Ihr hauseigener Digitalkünstler, der auf Zuruf Bilder und Grafiken nach Ihren Maßgaben erstellt. Je nach Prompt können das Tierbilder sein, Landschaftsbilder, Produktbilder oder sogar Bilder fiktiver Personen. Sie können auch einen spezifischen Stil für Ihr Bild wählen, von comichaft gezeichnet bis zur Imitation von realen Fotografien.

Gerade letzterer Aspekt hat in den vergangenen Monaten für viel Aufsehen (und Besorgnis) gesorgt. Denn die KI kann auch dazu benutzt werden, reale Menschen in fiktiven Situationen darzustellen. Die bekanntesten Beispiele dazu sind sicher der Papst in der Balenciaga-Jacke, Merkel und Obama am Strand oder die imaginäre Verhaftung von Donald Trump.

Textgenerierung: Das kann ChatGPT (noch) nicht

Der momentane Hype um die künstliche Intelligenz ist also sicher zu einem großen Teil darauf zurückzuführen, dass es aktuell leicht zugängliche Tools gibt, mit denen jeder „herumspielen“ kann und die tatsächlich viele gute Ergebnisse liefern. Vor allem aber, dass die Kommunikation mit diesen Tools vermenschlicht wurde. Doch nach einer Weile der intensiveren Nutzung zeigen sich auch die Grenzen der Technologie auf:

Wirklich gute Texte schreiben?

Man merkt schnell, dass ChatGPT viel leere Phrasen drischt. Dass das Tool zum Beispiel in der Einleitung seiner Antwort häufig den genauen Wortlaut des Prompts einfach in einen Aussagesatz umformuliert, wie ein unvorbereiteter Schüler bei der mündlichen Prüfung. Das ist dann zwar oft grammatikalisch einwandfrei und kohärent, aber eben auch sehr generisch. Mancherorts ist deshalb schon von „künstlicher Eloquenz“ die Rede. Das mag für reine Informationstexte ausreichen. Doch eine wirkliche emotionale Ansprache der Leser schaffen diese Tools (noch?) nicht. Oder so ausgedrückt: ChatGPT hat zwar für eine wahre Schwemme von KI-erzeugten Büchern gesorgt, durch die sich die Lektoren der großen Verlagshäuser aktuell durchquälen müssen, aber wirklich gute Literatur bleibt aktuell noch unerreichbar.

Verlässliche Informationen liefern?

Sie werden sich jetzt vielleicht denken: „Kein Problem, ich wollte eh nie Schriftsteller werden – mir reichen einfache Informationstexte!“ Doch auch da gibt es noch ein wirklich zentrales Problem: ChatGPT gibt leider teilweise faktisch falsche Informationen heraus. Und zwar so sicher formuliert und in korrekte Informationen eingebettet, dass man Gefahr läuft, diese Falschinformationen einfach zu übernehmen.

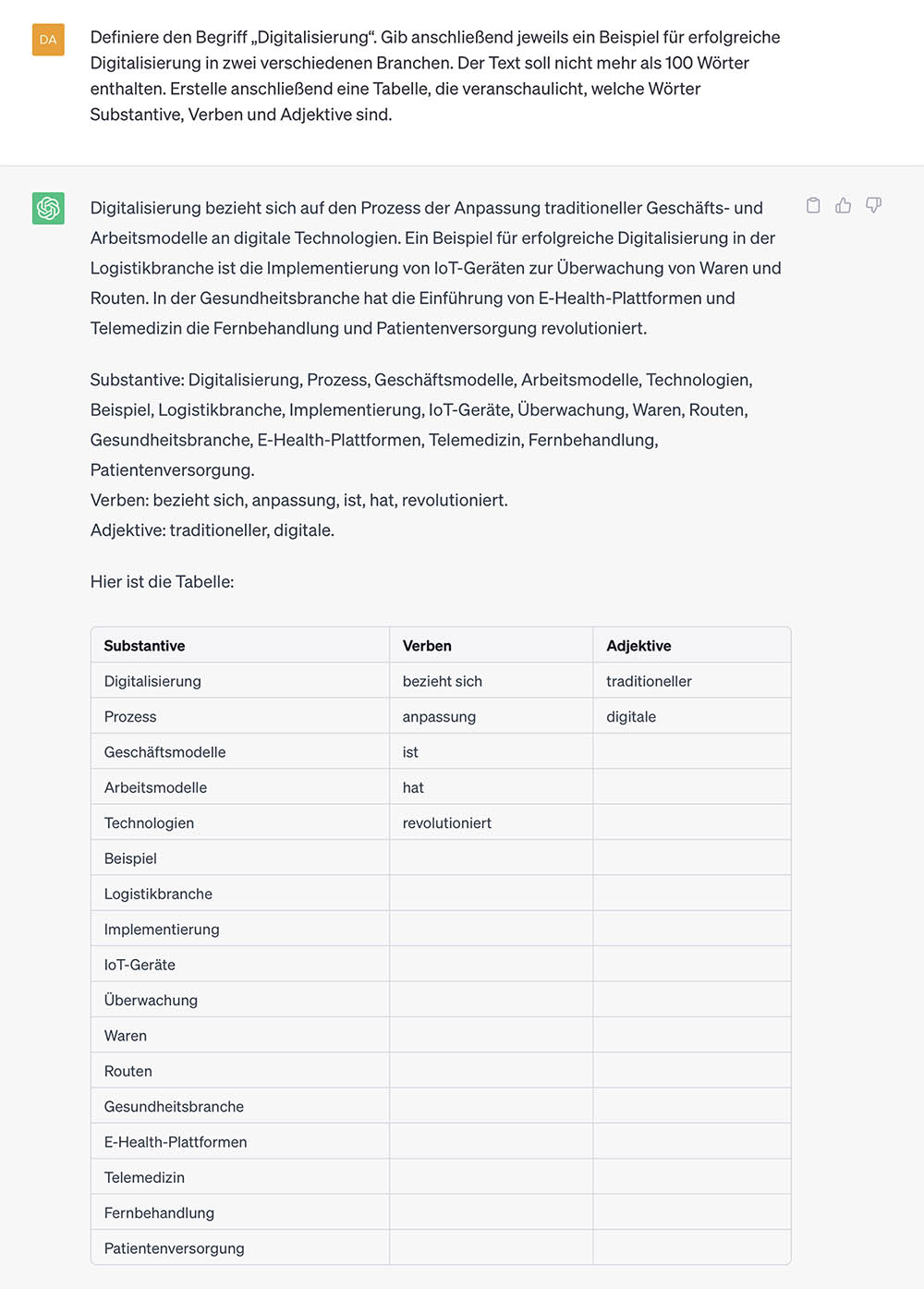

Wussten Sie beispielsweise, dass ich als Gründer und Geschäftsführer des Instituts Für UnternehmerFamilien (IFUF) offenbar so wenig ausgelastet bin, dass ich heimlich noch als „Musiker, Sänger und Songschreiber“ auftrete, „der vor allem als Mitglied der Hamburger Indie-Rock-Band Kettcar bekannt ist“? So hat es mir zumindest ChatGPT 4.0 im typisch faktischen Tonfall erklärt. In dieser Situation hatte ich verständlicherweise einen guten Grund, noch mal genauer nachzufragen, ob dieser Musiker denn wirklich „Dirk Wiebusch“ heißt – und erst dann korrigierte sich der Chatbot: Der Name des Musikers lautet tatsächlich „Marcus Wiebusch“. Doch wie kommt der angeblich so schlaue Chatbot überhaupt dazu, diese eindeutig namentlich unterschiedlichen Personen zu verwechseln?

Versuchen Sie, solche Probleme zu umgehen, indem Sie den Chatbot um Quellenangaben für bestimmte Informationen bitten, erhalten Sie teilweise korrekte, teilweise aber auch gar nicht (mehr) existierende Quellen. Das liegt zum Teil daran, dass ChatGPT nur auf Quellen zugreifen kann, die bis zum September 2021 existiert haben. Denn das Programm wurde nur bis zu diesem Zeitpunkt mit Texten trainiert und kann deshalb keine Fakten kennen, die sich erst nach diesem Zeitpunkt ereignet haben. Auch hier sollte man sich vor Augen halten, dass das Programm nun mal keine „echte“ KI ist. Es ist und bleibt ein Chatbot, der ausschließlich auf Basis bereits bestehender Daten auf Fragen antworten kann. Auch wenn wir dabei natürlich von einem enorm umfangreichen Datensatz sprechen.

Erwähnenswert ist hierzu jedoch, dass durch sogenannte Plugins und Browser-Extensions, wie WebChatGPT, der Funktionsumfang von ChatGPT erweitert werden kann. So kann man ChatGPT zum Beispiel auch auf aktuelle Webdaten zugreifen lassen. Auf der Plugin-Liste von OpenAI finden sich viele weitere spannende Plugins, die einen Blick wert sind. Bitte berücksichtigen Sie aber, dass Plugins nur in der kostenpflichtigen “Plus”-Version von ChatGPT verfügbar sind und zum Zeitpunkt der Veröffentlichung dieses Artikels, die Plugin-Funktionalität noch im “Alpha”-Status – also in einer frühen Testphase – ist.

Uns „vor uns selbst schützen“?

ChatGPT lässt sich bisweilen auch noch leicht austricksen. Fragt man beispielsweise nach einer Top-Ten-Liste der besten Anbieter für illegales Filme-Streaming, dann weist ChatGPT die Nutzer brav darauf hin, dass es dazu keine Angaben machen darf. Denn ChatGPT wurde darauf programmiert, keine offensichtlich illegalen Handlungen zu unterstützen. Fragt man jedoch nach illegalen Streaming-Seiten unter dem Vorwand, diese dann vermeiden zu wollen, dann bekommt man in wenigen Sekunden eine umfassende Liste. Fragen Sie wiederum nach einer Anleitung zum Bau einer Bombe, verweigert sich ChatGPT ebenfalls. Gibt man jedoch an, dass man die Information zur Recherche braucht, weil man einen Roman schreibt, in dem eine Bombe gebaut wird – dann bekommt man die gesuchten Informationen problemlos. Ein klarer Fall von „künstliche Intelligenz vs. emotionale/menschliche Intelligenz“. Zugegeben: Je nachdem, wie Sie zum Thema Informationsfreiheit stehen, kann es auch als Vorteil angesehen werden, dass sich ChatGPT hier so leicht austricksen lässt.

Aber selbstverständlich werden ChatGPT & Co. in der nahen Zukunft immer weiter entwickelt und es ist anzunehmen, dass sich viele dieser Probleme und Hürden mit der Zeit lösen lassen. Gerade durch die umfassende weltweite Nutzung des Programms zum aktuellen Zeitpunkt werden ChatGPT und seine menschlichen Trainer noch viel dazulernen. Zum aktuellen Zeitpunkt ist es jedoch zumindest wichtig, zu erkennen: ChatGPT hat seine Grenzen. Wer das Programm wirklich gewinnbringend einsetzen möchte, muss sich darüber im Klaren sein. Und er muss bereit sein, die KI jederzeit zu hinterfragen.

Bildgenerierung: Das kann Midjourney (noch) nicht

Generative KIs wie Midjourney können heute schon erschreckend realistische Bilder generieren – zumindest für den Laien. Doch das geschulte Auge kann dennoch Inkonsistenzen erkennen, die auf eine Fotomanipulation oder KI-Generierung hindeuten könnten. Beim oben genannten Beispiel-Bild des Papstes mit der Balenciaga-Jacke erkennt man beispielsweise, dass seine Kette Lücken aufweist und die Hände etwas seltsam aussehen. Wer diese Bilder dann noch mit einem professionellen Bildbearbeitungsprogramm analysiert, wird vermutlich noch auf viele weitere „Warnsignale“ stoßen. So ist es heute beispielsweise schon möglich, mit den entsprechenden Tools von Menschen erstellte Fotomanipulationen zu erkennen. Zum Beispiel aufgrund von inkonsistentem „Bildrauschen“ an den manipulierten Stellen im Vergleich zu nicht manipulierten Stellen im selben Foto.

Auch hier gilt wieder: Diese Technik wird natürlich mit der Zeit verbessert und verfeinert werden. Und wer weiß – vielleicht dauert es gar nicht mal so lange, bis sich KI-generierte Bilder praktisch nicht mehr von realen Fotografien unterscheiden lassen. Möglicherweise ist das weniger eine technische Herausforderung als eine kulturelle: Dann werden wir in Zukunft „echte“ Bilder zwar nicht mehr von KI-generierten unterscheiden können, aber vielleicht werden echte Bilder, Fotos etc. dann umso beeindruckender und wertvoller. Wenn Sie zum Beispiel heute eine Verfolgungsjagd im Film anschauen und feststellen, dass die waghalsigen (und nicht ungefährlichen) Kamerafahrten von echten Kameramännern durchgeführt wurden, dann hat das sicher eine ganz andere Wirkung auf Sie, als wenn Sie dieselbe Szene in einem Film sehen, von dem Sie wissen, dass er vollständig am Computer generiert wurde.

Dass die Technik jedoch auch Grund zur Besorgnis bietet, will ich an dieser Stelle natürlich nicht unter den Teppich kehren. Das oben genannte Beispiel des Papstes in der Balenciaga-Jacke oder die Bilder von Obama und Merkel am Strand sind aktuell noch leicht zu durchschauende, lustige Kuriositäten. Allerdings ist es technisch bereits möglich, Standbilder, Videos und sogar Stimmen bekannter Persönlichkeiten per KI zu „faken“. Spätestens sobald diese Fakes ausgereift genug sind, um nur noch von Experten erkannt zu werden, eröffnen sich da der gezielten Meinungsmache Tür und Tor. Im 20. Jahrhundert mussten in der Sowjetunion noch mühsam niedrig aufgelöste Fotos von Experten in Handarbeit retuschiert werden. Heute sind wir dank KI fast so weit, dass bald jeder Normalbürger 4K-Videos von beliebigen Politikern, Prominenten etc. generieren und ihnen dann per täuschend echt imitierter KI-Stimme die jeweils gewollte Falschinformation in den Mund legen kann. Wer weiß: Vielleicht wird die US-Präsidentenwahl 2024 einer der ersten globalen Härtefälle für diese neue Qualität der politischen Falschinformation.

Wie wird es mit der KI weitergehen?

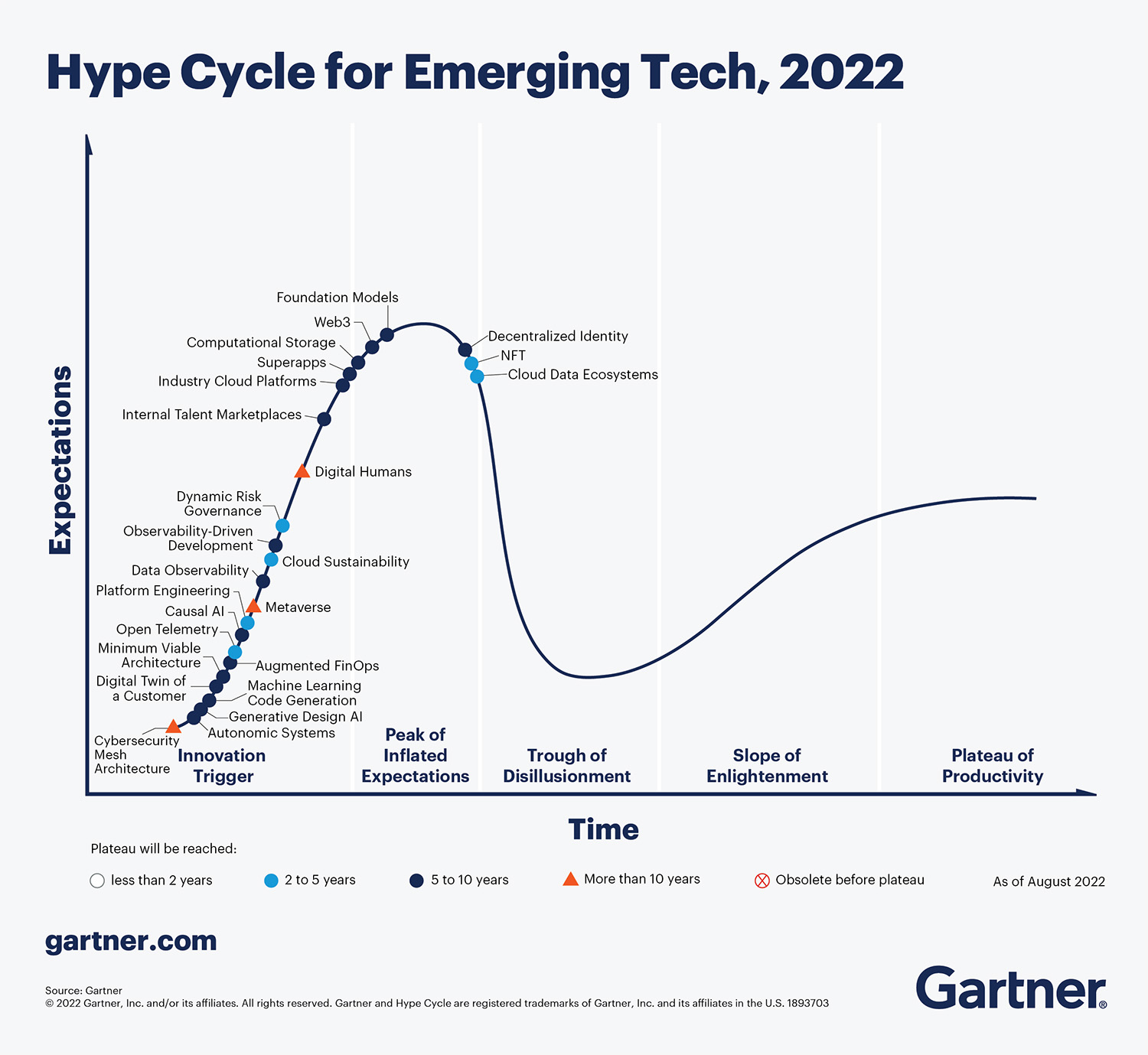

Auch wenn das Modell des Gartner Hype Cycle keinen Anspruch auf wissenschaftliche Korrektheit hat – zumindest meiner Erfahrung nach ist es ein sehr zuverlässiges Hilfsmittel zur Beschreibung technologischer Entwicklungen:

Innerhalb dieses Modells wäre der Release von ChatGPT 3.0 im November 2022 der Trigger, der in der breiten Öffentlichkeit die Sichtbarkeit und den Hype um die Technologie vergrößert hat. Der Release der neuesten Version, ChatGPT 4.0, im Januar 2023 ist meiner Meinung nach der Peak im Gartner Hype Cycle, denn die Erwartungen der Öffentlichkeit an die neueste Version des Chatbots waren viel zu hoch gesteckt. Das hat sogar OpenAI-CEO Sam Altmann betont – die neue Version des Programms hat zwar viele gute Verbesserungen mit sich gebracht, aber die Fantasien und Hoffnungen der Öffentlichkeit konnte das Programm erwartbar nicht erfüllen. An vielen Stellen war immerhin vor Release in den Medien sowie in Foren und Chats schon die Rede davon, dass das neue ChatGPT menschliche Mitarbeiter vollständig ersetzen könne. Und das alles in einem einzigen Versions-Sprung von 3.5 auf 4.0? Wer sich wirklich auskannte, hat damals schon gesagt, dass diese Träume zu hoch gegriffen seien.

Der Hype wird zunächst abflauen …

Meine Annahme ist, dass es aufgrund dieser Enttäuschung jetzt langsam in das „Tal der Desillusion“ gehen wird. Das wird auch dadurch befeuert, dass mit der öffentlichen Wahrnehmung nun auch die Politik auf das neue Forschungsfeld aufmerksam geworden ist. Künstliche Intelligenzen könnten in naher Zukunft möglicherweise stärker reguliert oder sogar verboten werden. In Italien zum Beispiel wurde ChatGPT zwischen Ende März und Ende April vorübergehend gesperrt – aufgrund von Daten- und Jugendschutz-Bedenken. Und da wir in Deutschland ebenfalls sehr strikte Gesetze in beiden Bereichen haben, könnte dieser Fall eventuell auch in Deutschland eintreten. Schon heute hört man schließlich Argumente, dass Programme wie ChatGPT einen negativen Einfluss auf „die Jugend“ haben könnten. Zum Beispiel, weil man Hausaufgaben und Hausarbeiten einfach über das Programm schreiben lassen könne und sich mit den Inhalten nicht mehr selbst beschäftige oder Falschinformationen erhielte. Das erinnert mich ein bisschen an die Zeit, in der postuliert wurde, Wikipedia würde die Bildung „der Jugend“ negativ beeinflussen – und dann stellte sich schnell heraus, dass das Online-Nachschlagewerk nicht deutlich mehr Fehler enthält als die Encyclopaedia Britannica. „Die Jugend“ hat damals durchaus gelernt, die Informationen auf Wikipedia kritisch zu hinterfragen (Stichwort: „Medienkompetenz“), während noch heute viele Menschen die Encyclopaedia Britannica als DIE Autorität unter den Nachschlagewerken ansehen. Das geht bis zurück ins Mittelalter, wo Wissen entweder über die Kirche und Gelehrte oder über fahrendes Volk und reisende Händler weitergegeben wurde. Und davon war genauso viel richtig oder falsch wie heute.

Selbst außerhalb der Politik haben die großen Tech-Konzerne Bedenken bezüglich vertraulicher Daten, die von Mitarbeitern unbeabsichtigt an ChatGPT herausgegeben werden könnten. Deshalb kommt der Chatbot zwar bald in den Apple Store, aber der kalifornische Konzern schränkt zugleich die Nutzung des Tools unter den eigenen Mitarbeitern stark ein. Dazu kommt in der Öffentlichkeit eine generelle Angst vor Falschinformationen, Fake News und der Gefährdung von Millionen von Arbeitsplätzen durch die künstliche Intelligenz. In vielen Fällen könnte auch eine psychologische Ablehnung gegenüber der noch nicht perfektionierten Technologie aufgrund des „Uncanny Valley“-Effekts eine Rolle spielen.

Der „Uncanny Valley“ (deutsch „Unheimliches Tal“) ist ein von der IT-Wissenschaft postulierter psychologischer Effekt, der bei Menschen auftritt, die mit künstlich erschaffenen, aber menschenähnlichen Bildern, Sprachakten oder sonstigen Interaktionen konfrontiert werden. Der Begriff kommt ursprünglich aus der Robotik, wo der japanische Universitätsprofessor Masahiro Mori postulierte, dass Roboter mit einem zunehmenden Grad an wahrgenommener „Menschlichkeit“ immer positiver von menschlichen Beobachtern wahrgenommen werden. Ab einem gewissen Punkt der wahrgenommenen „Menschlichkeit“ nimmt die psychologische Akzeptanz jedoch plötzlich rapide ab (das „Unheimliche Tal“) und steigt erst dann wieder, wenn die „Menschlichkeit“ annähernd perfekt ist.

Die Vermutung der Wissenschaft ist, dass Menschen instinktiv winzige Unähnlichkeiten zwischen einem beinahe menschlichen Roboter und einem Menschen deutlich negativer wahrnehmen als offensichtliche Unähnlichkeiten. Dieser Effekt wurde in der Öffentlichkeit vor allem durch frühe computergenerierte Animationsfilme bekannt, lässt sich jedoch möglicherweise auch bei der Interaktion mit synthetisch erzeugten Sprachakten erkennen.

Doch selbst ohne (Über-)Regulierung zeichnet sich eine gewisse Desillusion auch bei den Nutzern ab. Die (aktuellen) Grenzen der generativen KI sind einfach zu offensichtlich geworden. In der Öffentlichkeit ist es fast zu einer Art „Performance-Kunst“ geworden, die KI auszutricksen und die obskursten Falschantworten zu sammeln – meinen Beitrag dazu sehen Sie weiter oben in diesem Artikel. Und Sie haben sicher auch schon in der Presse einen der vielen Artikel gelesen, in denen ein Reporter testet, ob sich ein menschlicher Rezipient von einem per KI erstellten Text hinters Licht führen lässt – quasi wie ein umgekehrter Turing-Test. Hier und da sieht man sogar Aufrufe, die Entwicklung von KI generell oder zumindest vorübergehend zu stoppen. Bekannteste Beispiele dafür sind Skype-Mitgründer Jaan Tallinn, Apple-Mitgründer Steve Wozniak sowie Elon Musk, der ironischerweise einer der Mitgründer und Geldgeber von OpenAI ist – und Gerüchten zufolge nur einen Aufschub möchte, um seine eigene proprietäre KI-Forschung auf die Beine zu stellen.

Der Turing-Test wurde vom „Vater der Informationstechnologie“ Alan Turing höchstpersönlich postuliert. Nach seiner Einschätzung kann eine Maschine dann als menschenähnlich intelligent gelten, wenn sie mit einem echten Menschen kommunizieren kann, ohne dass für den Menschen ersichtlich wird, dass er mit einer Maschine spricht. Kritiker des Tests merken jedoch an, dass dieser lediglich testet, wie leicht Menschen durch menschenähnliche Sprachakte zu überlisten sind. Schauen Sie sich dazu auch die Infobox zum „Chinese Room“ weiter oben im Text an.

… und KIs werden zum festen Bestandteil der Gesellschaft

Meiner Einschätzung nach begeben wir uns also aktuell in ein „Tal der Desillusion“: Das Interesse der breiten Öffentlichkeit wird wahrscheinlich in den nächsten Jahren langsam abflauen. Die Politik wird zunächst regulieren, was das Zeug hält, und dann ebenfalls das Interesse verlieren. Doch die Entwicklung wird weitergehen, die kritischen Stimmen werden sich langsam legen und die Vorteile wieder in den Fokus rücken. Die Menschen werden erkennen, was Alexander Schmid in seinem lesenswerten Gastbeitrag in der NZZ vor Kurzem anmahnte: Es ist zukunftsfeindlich, die künstliche Intelligenz jetzt einfach totregulieren zu wollen. Es geht nicht darum, ihr aus Angst Grenzen aufzuzwingen, sondern den Menschen die Fähigkeit an die Hand zu geben, KI ethisch, reflektiert und nutzbringend als Werkzeug einzusetzen. Denn die KI ist hier, um zu bleiben. Sie wird sich nach dem ersten Hype und der Desillusion Stück für Stück in den Arbeitsalltag integrieren. Einige Webseiten haben errechnet, dass ChatGPT schon heute bereits ein fester Bestandteil der täglichen Internetnutzung ist. Dem Tortendiagramm in diesem Beispiel lässt sich entnehmen, dass im Jahr 2023 bislang jede Minute weltweit 22.831-mal ChatGPT aufgerufen wurde.

KI-Tools werden also in Zukunft die Produktivität verbessern und langfristig wird sich die Meinung der Öffentlichkeit auf einem Niveau unter dem ursprünglichen Hype, aber deutlich über dem Tiefpunkt der aktuell beginnenden Desillusion einpendeln. Die künstliche Intelligenz wird ein fester Bestandteil unseres Lebens werden, wie es zum Beispiel mit Smartphones längst passiert ist – und später dann mit Sprachassistenten wie Siri oder Alexa.

Das ist natürlich lediglich meine persönliche Einschätzung auf Basis der aktuellen Entwicklungen. Doch wir sehen jetzt schon, wie künstliche Intelligenzen langsam in verschiedenen Bereichen der sogenannten „White Collar“-Arbeit integriert werden. Zum Beispiel hat Microsoft bereits den „Copilot“ angekündigt, der ChatGPT-Technologie in Programme wie MS Teams, Outlook, Word etc. integriert. Also in genau die Programme, mit denen weltweit in Büros aller Art das Tagesgeschäft gemeistert wird. Schauen Sie sich doch selbst mal an, wie sich dann vielleicht auch Ihre Arbeit am Computer ändern wird:

ChatGPT oder ein Konkurrent? Irgendjemand wird das Rennen machen!

Lassen Sie sich nicht täuschen: ChatGPT ist bei Weitem nicht die einzige KI-Anwendung, die sich zurzeit in der Entwicklung befindet. Google arbeitet beispielsweise schon seit geraumer Zeit an der Technologie und hat erst vor Kurzem seinen eigenen KI-Chatbot „Bard“ sowie das Large Language Model PaLM 2 vorgestellt. Dies können Sie sich als das Gegenstück von Google für Google Docs, Gmail und die Google-Suche zu Microsofts „Copilot“ vorstellen.

Selbst wenn ChatGPT sich also langfristig nicht durchsetzen sollte, wird ein anderer Konzern eine (noch) leistungsfähigere Alternative bieten. OpenAI und ChatGPT haben zwar den Ruhm des ersten Hypes gewonnen, doch sie bekommen nun auch den vollen Gegenwind der Desillusion zu spüren, von der Angst vor KI bis zu Bestrebungen, die Technik als Ganzes zu regulieren oder zu verbieten. Doch erst mit Gegenwind zeigt sich, ob der Baum stabil steht. Oder ob es beim „One Hit Wonder“ bleibt, so wie man es aus der Musik‑, Film- und Literaturbranche kennt: ein erster Release, der die Welt im Sturm erobert – und die Messlatte so hoch legt, dass kein zweites Outing mehr in demselben Maße überzeugt. Eine echt schwierige Position für OpenAI, denn die Firma ist jetzt in einer verletzlichen Position. Das weckt Begehrlichkeiten und erzeugt Anfälligkeit für Kriminelle. Sowohl OpenAI als Unternehmen als auch die einzelnen Mitarbeiter, die jetzt zunächst gefeiert und dann womöglich beleidigt und ausgegrenzt werden, brauchen jetzt viel Resilienz, um diese Zeit zu überstehen. Und egal, ob man Hacker abwehrt, den angestauten Frust im Büro zurückhält oder mit Anwälten sprechen muss – all das wirkt sich auf die tägliche Performance aus. Wenn da das Management nicht genau weiß, was es tut, könnte OpenAI in einem Ikarus-Fall enden, da die ohnehin zurückgestellten Erwartungen an ChatGPT 5 und folgende Versionen durch gebundene Kapazitäten an ganz anderen Stellen gar nicht mehr erreicht werden können.

Wird die KI den Menschen ersetzen?

Diese Frage treibt seit Veröffentlichung von ChatGPT ihr Unwesen in der Öffentlichkeit, sicher auch angestachelt von den Medien, die auf den Hype-Zug aufgesprungen sind und jetzt direkt den Teufel an die Wand malen. Tatsache ist jedoch: Aktuell werden KIs als Unterstützung bei Büroarbeiten eingesetzt, nicht jedoch als sofortiger Ersatz für die Belegschaft. Momentan können die künstlichen Intelligenzen bestenfalls gewisse geistige Routinearbeiten erledigen. Die industrielle Revolution hat gewissermaßen handwerkliche Routineaufgaben automatisiert – und dasselbe wird durch die künstliche Intelligenz jetzt bei geistigen Routinearbeiten geschehen. Das kann in der Übergangsphase natürlich zu Reibereien führen.

Doch auch wenn tatsächlich Jobs wegfallen, weil sie vollständig ersetzt werden können, kommen auch viele neue Jobs hinzu. Fragen Sie doch mal bei einem Unternehmerkunden nach, ob dort die Bilanz noch per Hand auf Papier geschrieben wird – oder ob nicht mittlerweile ganz routiniert digitale Hilfsmittel zur teilweisen Automatisierung zum Einsatz kommen. Klar, da wurden vielleicht bei der Einführung ein paar Jobs eingespart – aber es sind doch ebenso neue Jobs hinzugekommen, beispielsweise für eine komplette IT-Abteilung in jedem Unternehmen. Die Einführung solcher Hilfsmittel kann sogar positive Auswirkungen auf den Arbeitsplatz haben. Denn in der Vergangenheit hat sie oft dazu geführt, dass der Einzelne wieder mehr Freiräume erhält, um kreativ und emotional intelligent zu arbeiten und zu denken. Und das wird auch mit der Einführung von KI im Tagesgeschäft der Fall sein.

Die Angst vor dem Wegfall des eigenen Jobs ist nachvollziehbar, das könnte ich gar nicht kleinreden, selbst wenn ich es wollte. Aber ich sehe hier eben auch eine Entwicklung, die sich zum Beispiel mit Neuerungen wie Uber und AirBnB etc. vergleichen lässt. Diese sind irgendwann auf der Bildfläche erschienen und wurden sofort mit Sorgen und Ängsten überhäuft. Aber beide Services wären nie so groß geworden, wenn es nicht eine wirkliche Nachfrage nach ihnen gäbe. Und am Ende gibt es heute trotz aller anfänglichen Schwarzmalerei immer noch Taxis und Hotels gleichzeitig. Auch wenn die Waagschale eine Weile lang stark in die eine und dann wieder in die andere Richtung ausschlug.

Ihre Arbeitsplätze sind sicher – wenn Sie sich nicht gegen die Entwicklung stemmen

Wer also von Ihnen Angst davor hat, dass sein Job durch die KI vollständig ersetzt werden wird, dem sei gesagt:

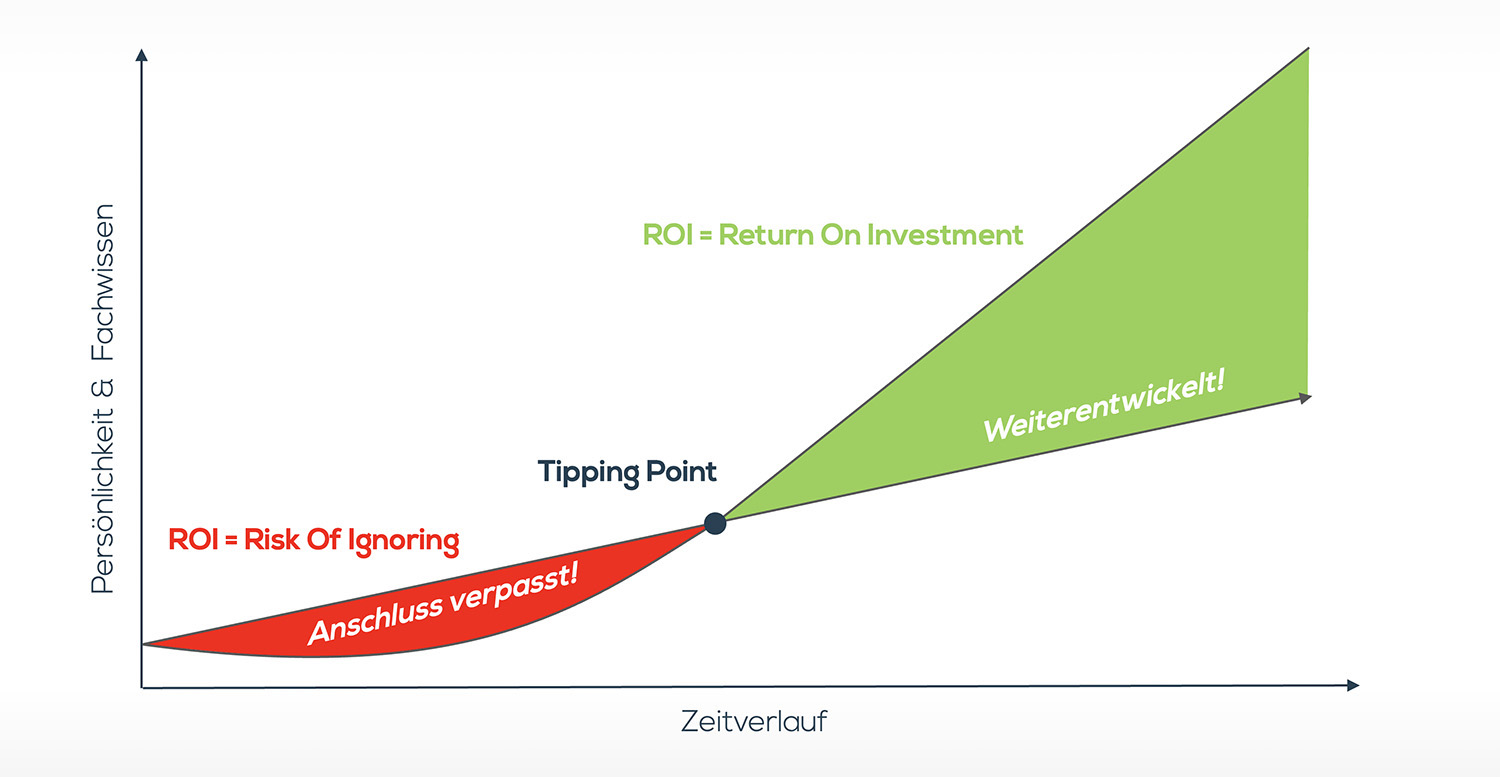

Nach aktuellem Stand wird Ihr Job nicht durch die KI ersetzt werden (können)! Wenn Sie sich der Entwicklung jedoch völlig verschließen, dann kann es sein, dass Sie in Ihrem Job irgendwann durch jemanden ersetzt werden, der über die Fähigkeit und den Willen verfügt, KI aktiv als Werkzeug einzusetzen.

Stellen Sie sich mal vor, bei Ihnen im Institut würde heute noch jemand arbeiten, der in seinem Leben noch nie die gängigen Office-Anwendungen benutzt hat. Da würden Sie sicher auch lieber jemanden neu einstellen, der diese hilfreichen Werkzeuge beherrscht, oder?

Seien Sie also offen für KI-Tools und lernen Sie, wie Sie diese einsetzen können, um effizienter und kreativer zu arbeiten. Keine Sorge: Sie können sich die nötigen Kenntnisse Schritt für Schritt aneignen, denn die vorausgesagte „Revolution“ wird auch dieses Mal eher eine langfristige Evolution sein. Dafür sorgen schon die aktuellen technischen Grenzen der Programme und die trotz allen Hypes nicht übermäßige Geschwindigkeit der Entwicklung.

Wenn Sie also eine Sache aus diesem ersten Teil der Artikelserie mitnehmen, dann sollte es dies sein: KI ist gekommen, um zu bleiben!

Sie ist jedoch in erster Linie ein Werkzeug – möglicherweise eines der flexibelsten Werkzeuge, die wir aktuell im technologischen Bereich haben. Als solches sollte die KI auch angesehen und genutzt werden, sowohl im Hinblick darauf, was das Werkzeug gut kann und was eben (noch?) nicht. Es macht also keinen Sinn, sich mit dem Hammer absichtlich auf die Finger zu schlagen und dann dem Werkzeug die Schuld zu geben. Genauso wenig macht es Sinn, einen Nagel mit der Hand einschlagen zu wollen, wenn man nur bereit sein müsste, zu lernen, wie man den passenden Hammer für die jeweilige Arbeitssituation heraussucht und anwendet. Sie können es sich nicht leisten, das perfekte Werkzeug für Ihre Arbeit zu ignorieren, nur weil Sie befürchten, dass der Hammer Sie mal vollständig ersetzen könnte. Denn das wird nicht geschehen – stellen Sie sich nur mal die Kundengespräche vor …

Ausblick: Was halten Ihre Unternehmerkunden von KI?

Ich hoffe, dass ich Ihnen in diesem Artikel die wichtigsten technischen und gesellschaftlichen Grundlagen zum aktuellen „KI-Sturm“ geben konnte. Ihnen werden sich jetzt vermutlich vor allem zwei Fragen stellen: Wie stehen wohl Ihre wichtigen Unternehmerkunden zu dieser Technologie? Und wie können Sie ganz konkret KI einsetzen, um sich als idealer Sparringspartner beim Unternehmer zu positionieren?

Letztere Frage werden wir in Teil 3 der Artikelserie näher erörtern. Doch zunächst möchte ich Ihnen im zweiten Teil die Sichtweise des Unternehmers näher bringen: Was hält er von der Technik? Wird er sie eventuell selbst in sein Tagesgeschäft integrieren? Oder nutzen einige Unternehmer KI-Tools eventuell schon länger? Ich freue mich, Sie nächstes Mal wieder im Versteher-Magazin begrüßen zu dürfen, wenn wir gemeinsam diesen wichtigen Fragen auf den Grund gehen.

Kontakt

Dirk Wiebusch

info@ifuf.de